Scaling Responsible AI Solutions (SRAIS) | Cohorte Internationale 2024

Description et contexte

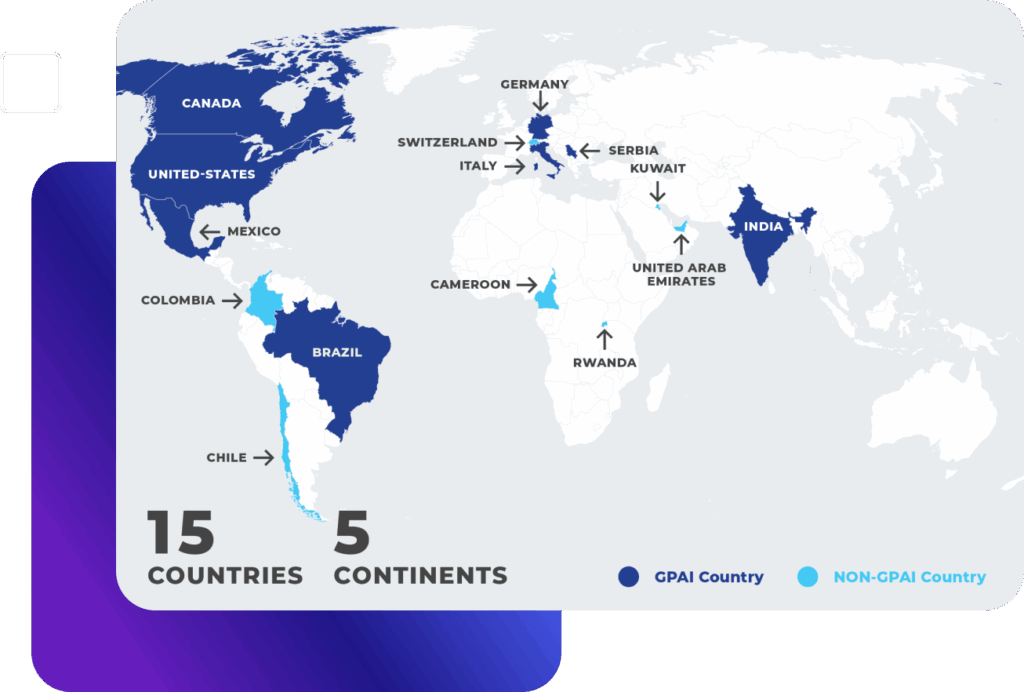

Le cycle SRAIS 2024 a marqué la deuxième année d’une initiative mondiale en pleine expansion menée par le GPAI et le CEIMIA. Cette année, le projet a élargi son champ d’action et consolidé sa méthodologie, aidant 21 équipes d’IA à travers le monde à relever les défis qui se posent lorsque les principes responsables se heurtent aux réalités de la mise à l’échelle et à des défis tels que la gouvernance des données, l’intégration culturelle, la conformité réglementaire, l’interopérabilité et les impacts sociaux, économiques et environnementaux plus larges des systèmes d’IA.

Grâce à un programme de mentorat structuré, le SRAIS 2024 a mis en relation des innovateurs avec des mentors experts afin d’identifier les obstacles prioritaires et d’élaborer des stratégies concrètes, tout en produisant des idées et des recommandations qui vont au-delà des équipes individuelles. En combinant des conseils personnalisés et le partage de connaissances, le cycle de cette année a favorisé la création d’une communauté internationale de pratique dédiée à la mise à l’échelle responsable de l’IA, renforçant ainsi la crédibilité et la compétitivité des approches responsables sur les marchés mondiaux.

Veuillez noter que tous les noms des personnes, des organisations et de leurs affiliations mentionnés sur le site web reflètent leur statut au moment de la publication du rapport couvrant ce programme de mentorat SRAIS. Nous reconnaissons que les noms et les affiliations peuvent évoluer au fil du temps.

Partenaires

Partenariat mondial sur l'IA (GPAI)

Le Partenariat mondial sur l’intelligence artificielle (GPAI) est un partenariat intégré qui rassemble les membres de l’OCDE et les pays du GPAI afin de faire avancer un programme ambitieux visant à mettre en œuvre une intelligence artificielle (IA) centrée sur l’humain, sûre, sécurisée et fiable, incarnée dans les principes de la recommandation de l’OCDE sur l’IA.

Centre international d'expertise en intelligence artificielle de Montréal (CEIMIA)

Le CEIMIA se positionne comme un acteur clé dans le développement responsable de l’intelligence artificielle, fondé sur les principes d’éthique, de droits de l’homme, d’inclusion, de diversité, d’innovation et de croissance économique. Le CEMIA mène des projets à fort impact dans le domaine de l’IA responsable grâce à une diplomatie scientifique influente à l’échelle internationale.

Objectifs

SRAIS vise à aider les innovateurs en IA du monde entier à développer leurs solutions de manière responsable, en leur fournissant un mentorat pratique qui comble le fossé entre les principes de l’IA responsable et leur mise en œuvre dans le monde réel.

Cette vision stratégique va au-delà des projets individuels, avec pour objectif de consolider une communauté mondiale de pratique dédiée à l’IA responsable et évolutive.

Grâce à cet effort collaboratif, notre objectif est de créer un échange enrichissant de connaissances et de bonnes pratiques, renforçant à la fois la crédibilité et la compétitivité des approches responsables en matière d’IA sur la scène mondiale.

Points forts et conclusions

En 2024, la deuxième édition du projet GPAI SRAIS, parrainé par le CEIMIA et le Partenariat mondial sur l’IA, a attiré des participants du monde entier à son programme de mentorat. Au cours de cette dernière année, le projet a pris de l’ampleur et a eu un impact croissant. Il a également fait des progrès considérables vers la consolidation d’un réseau mondial de

collaboration et de partage des connaissances, avec la création d’un volet SRAIS indépendant et complémentaire en Afrique. Les équipes et les experts polonais se sont révélés être une communauté particulièrement investie de praticiens de l’IA, faisant preuve d’un engagement fort en faveur d’une IA responsable.

L’équipe Orange Innovation Pologne a obtenu la reconnaissance « Responsible AI Changemaker » pour son travail innovant sur deux projets : une « solution de traçabilité » qui concilie confidentialité et amélioration continue de la personnalisation des produits, et un document décrivant les utilisations, les objectifs et les « règles d’engagement » d’un système de reconnaissance de la satisfaction qui améliore les interactions avec les agents virtuels.

Les discussions plus larges entre les experts et les équipes ont permis de générer davantage d’idées utiles pour l’avancement ou la pratique d’une IA responsable.

Une mise à l'échelle responsable est complexe

Il ne suffit pas d’intégrer les principes de l’IA responsable dès la phase de conception, la responsabilité doit être maintenue tout au long du cycle de vie, de la conceptualisation au déploiement mondial.

Une vision à long terme est nécessaire

Les systèmes d’IA doivent être évalués non seulement en fonction des risques immédiats (biais, confidentialité, sécurité), mais aussi en fonction de leurs répercussions sociales, économiques et développementales plus larges, notamment leurs effets sur les droits humains, les moyens de subsistance et la durabilité.

La responsabilité ne peut être automatisée

Les solutions techniques sont essentielles, mais une véritable responsabilité nécessite un dialogue continu, une collaboration et une gouvernance partagée entre les parties prenantes.

Les compromis sont interdépendants

Les efforts visant à améliorer l’équité, la confidentialité ou la robustesse dans un domaine peuvent créer de nouveaux défis en matière de gouvernance des données, de pratiques de travail ou d’impact environnemental.

Nécessité d'une meilleure connaissance de la RAI

Les développeurs, les régulateurs et les utilisateurs manquent souvent d’une compréhension nuancée des principes de l’IA responsable. Le mentorat et le partage des connaissances, comme le démontre la SRAIS, sont essentiels pour renforcer les capacités et intégrer la responsabilité dans les pratiques de mise à l’échelle.

Équipes participantes

ASLAC (Automatic Sign Language Avatar Creation) – Migam.ai (Poland)

Description

Service de traduction en langue des signes basé sur le cloud utilisant l’IA/des avatars pour améliorer l’accessibilité des utilisateurs sourds et malentendants à l’échelle mondiale.

Résumé des progrès réalisés en IA responsable

Élaboration d’un cadre pour l’acquisition et la gestion responsables des données de formation vidéo, garantissant la confidentialité des personnes concernées et le respect de la propriété intellectuelle. Conception d’une « salle blanche de données » pour dépersonnaliser les données de formation sensibles.

Témoignage

« Le mentorat a souligné l’importance d’aller au-delà de la confidentialité des utilisateurs pour protéger également les personnes concernées dans les ensembles de formation, ce qui nous a permis d’élaborer un plan concret pour évoluer de manière responsable. »

Jalisco Diabetic Retinopathy Detection & Referral (Mexique)

Description

Outil prédictif basé sur l’IA pour détecter la rétinopathie diabétique et faciliter l’orientation dans les milieux cliniques, développé en collaboration avec le gouvernement de l’État de Jalisco.

Résumé des progrès réalisés en IA responsable

Travail sur l’alignement des résultats avec les besoins cliniques locaux, création de stratégies sécurisées à long terme pour le partage/stockage des données et garantie de l’intégration dans les flux de travail médicaux. Accent mis sur la transparence, l’explicabilité et l’impact environnemental.

Personality AI – Orange Innovation Poland

Description

Système d’hyper-personnalisation basé sur le cadre OCEAN, fonctionnant localement sur les appareils des utilisateurs sans transmission de données personnelles à l’extérieur.

Résumé des progrès réalisés en IA responsable

Création d’une « solution de traçabilité » et d’un tableau de bord « Privacy Guardian » afin de maintenir la pertinence de la personnalisation tout en protégeant la vie privée et en garantissant le consentement éclairé.

PredictGAD – ICGEB (Inde)

Description

Modèle d’IA facilitant le diagnostic du glaucome en analysant les scans ASOCT afin de détecter une dysgénésie angulaire.

Résumé des progrès réalisés en IA responsable

Élargissement de la diversité des ensembles de données afin de réduire les biais démographiques, garantie de l’explicabilité et exploration de cadres pour la confidentialité des données des patients et les mécanismes de suivi.

Gestion des performances, apprentissage et développement des employés (Pologne)

Description

Plateforme d’IA pour le développement, la formation et la gestion des performances des employés.

Résumé des progrès réalisés en IA responsable

Accent mis sur la transparence et la clarté afin que les utilisateurs comprennent comment les tâches, les recommandations et les récompenses sont générées, que ce soit par les responsables ou par le système.

Knowledge Chat – Websensa (Pologne)

Description

Assistant basé sur le modèle LLM permettant aux organisations d’interroger leurs bases de connaissances internes.

Résumé des progrès réalisés en IA responsable

Élaboration de lignes directrices complètes et spécifiques au public cible afin d’atténuer les hallucinations et de garantir la transparence, la sécurité des données et l’explicabilité.

Satisfaction Recognition in AI Conversations (Poland)

Description

Système d’IA permettant de mesurer et de reconnaître la satisfaction des utilisateurs lors des interactions.

Summary of RAI progress

Définition d’objectifs, de lignes directrices pour une utilisation sûre et de cadres de responsabilité afin de prévenir toute manipulation, inexactitude ou perturbation de l’expérience utilisateur.

Collaborateur IA responsable – AgentAnalytics.AI (Inde)

Description

Plateforme d’orchestration LLM multi-agents fournissant des « collaborateurs IA » aux PME, surveillée par des agents de contrôle RAI.

Résumé des progrès réalisés en IA responsable

Axée sur l’équité dans l’orchestration multi-agents et la prévention des fuites de données privées, tout en définissant comment la responsabilité s’adapte à des cas d’utilisation flexibles.